Uno de los términos más utilizados, investigados y quizás abusados en el ámbito de los datos y la analítica hoy en día es “aumentado”. Se requiere que todo sea aumentado a menudo antes de que exista: una contradicción en los términos porque por definición puedo aumentar algo que ya tengo. Y así hablamos de calidad de datos aumentada… cuando aún no tenemos calidad de datos, catálogos de datos aumentados… cuando no sé qué es un catálogo de datos o aún no lo he implementado, etc.

Peor aún, a veces definimos lo aumentado como algo que simplemente forma parte de lo que una herramienta, un software, un proceso siempre ha podido hacer… aunque no lo hayamos llamado así.

Pero, ¿qué significa entonces “aumentar” un proceso? ¿Cuál es la diferencia entre aumento y automatización? ¿Cuáles son las posibilidades reales de aplicación? ¿Por dónde empezar?

Quizá sería útil poner las cosas en orden, comparar notas e intentar entenderse un poco para que la innovación no se quede en eslóganes sino que aporte valor.

Algo parecido ocurre cuando hablamos de #DataFabric. ¿Sabemos qué es?

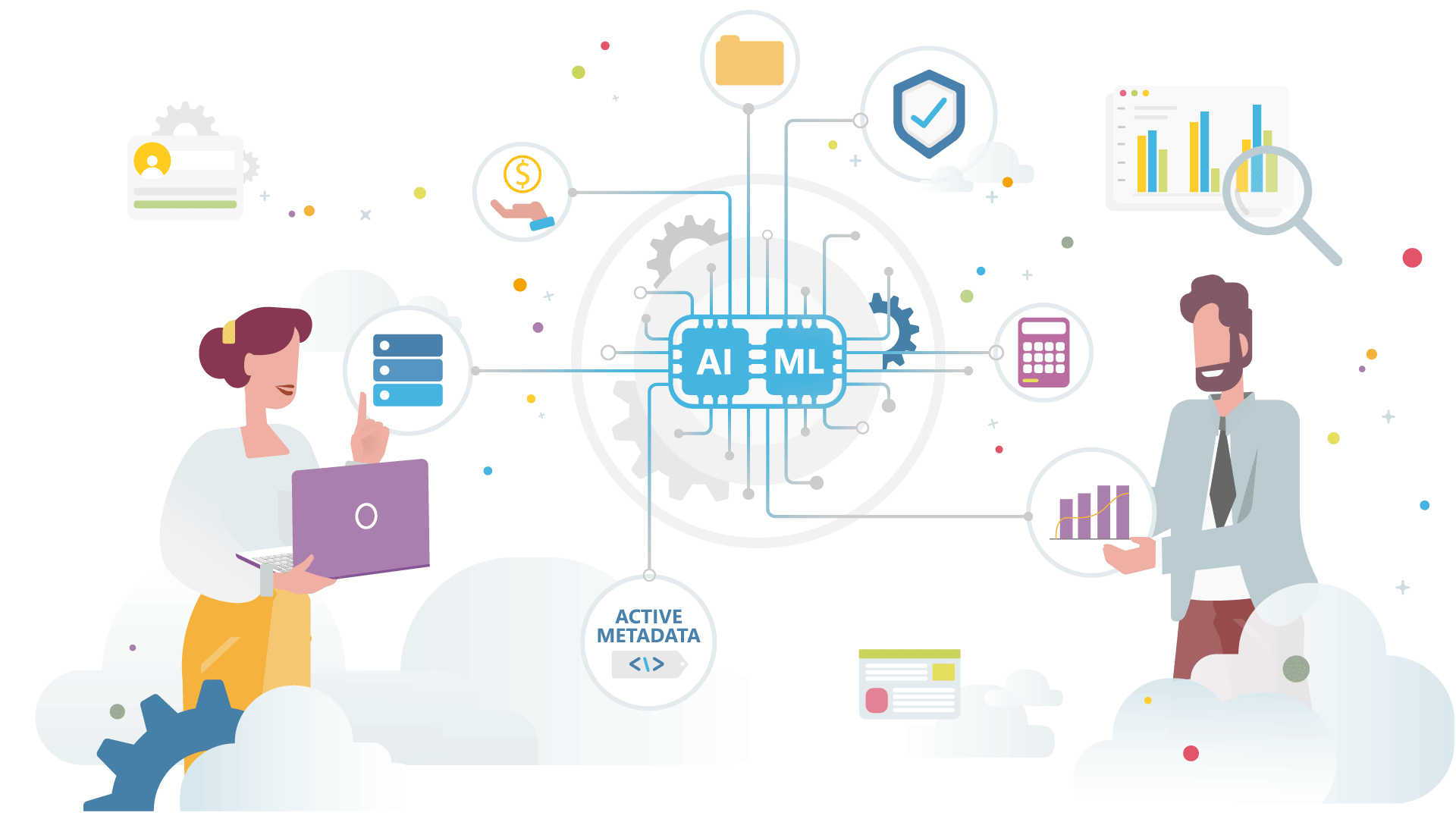

Es interesante observar que el concepto de Data Fabric abarca y resume una decena de las “principales tendencias” identificadas por Gartner® para la gestión de datos (véase la guía de planificación de Gartner 2020 para la gestión de datos). He aquí un breve extracto de la definición que Gartner da del Data Fabric:

El Data Fabric lleva los datos de una fuente a un destino de la manera más óptima, supervisa constantemente los data pipelines para sugerir y eventualmente tomar rutas alternativas si son más rápidas o menos costosas – al igual que un coche autónomo. Al principio, el Data Fabric será semiautónomo en los casos en que se requiera la intervención humana, pero con el tiempo la idea es que sea totalmente autónomo. Los consumidores de datos navegarán por un catálogo de datos, sin saber dónde residen, elegirán los datos que necesitan y el Data Fabric les proporcionará los datos de la manera más óptima en términos de rendimiento, esfuerzo y coste.

Gartner® – Desmitificando el Data Fabric – Publicado el 17 de septiembre de 2020 – Por el analista Jacob Orup Lund

¿Lo has leído bien?

Creo que el gran mérito y la utilidad de empresas como Gartner, que hacen análisis de mercado y trabajan como puente entre la oferta y la demanda, es precisamente el de captar tendencias, ofrecer ideas, estimular a los actores, fomentar la innovación, ir muchas veces más allá de lo que hoy puede parecer razonable, porque mañana puede no serlo.

Nuestra tarea es aceptar el reto, innovar, pero de tal manera que las cosas, aunque mirando al futuro, ¡se hagan realmente hoy!