L’esplosione della Generative AI modifica e allarga i confini della Data Quality: costruire il miglior modello di AI costituisce un’impresa difficile senza grosse moli di dati che siano giudicati affidabili. Tutte le aziende hanno oggi un estremo e urgente bisogno di mettere sotto controllo la qualità delle informazioni utilizzate nei propri processi data intensive e devono farlo in modo capillare, strutturato, flessibile e sostenibile. Da un lato, infatti, la quantità di dati e informazioni che i modelli ML e AI richiedono per funzionare amplifica i rischi derivanti dalla scarsa qualità di tali informazioni e rende necessario un presidio (AI Governance). Dall’altro l’intelligenza artificiale può essere di grande supporto nei processi di Data Quality (es. Augmented Data Quality), dalla progettazione fino alla esecuzione dei controlli stessi.

Generare valore, governando

L’attenzione alla qualità del dato ha vissuto diverse fasi nel tempo: da tema per lo più sconosciuto e relegato a questione tecnica per addetti ai lavori, poi attività limitata all’introduzione di controlli per la validazione dei dati nei processi operativi (ad esempio, i check di primo livello), a requisito vincolante per la conformità normativa che in alcuni settori (come la Finanza o l’Energy e Utility) ha imposto l’attivazione di presidi e controlli di secondo livello, fino a diventare una vera e propria disciplina.

La Data Quality si è ritagliata quindi un segmento di mercato specifico all’interno della più vasta arena del Data Management, un vero e proprio ecosistema fatto da vendor di tecnologia, consulenti, advisor, analisti, buyer, Data Quality “personas” nelle organizzazioni, ecc. Disciplinare però vuol anche dire governare, assegnare responsabilità, definire budget, controllare gli investimenti fatti per generare valore dalla qualità delle informazioni utilizzate. Il termine disciplina richiama la necessità di definire metodologie, tecniche, strumenti, adottare best practices, configurare processi.

Il white paper “La fabbrica dei controlli”

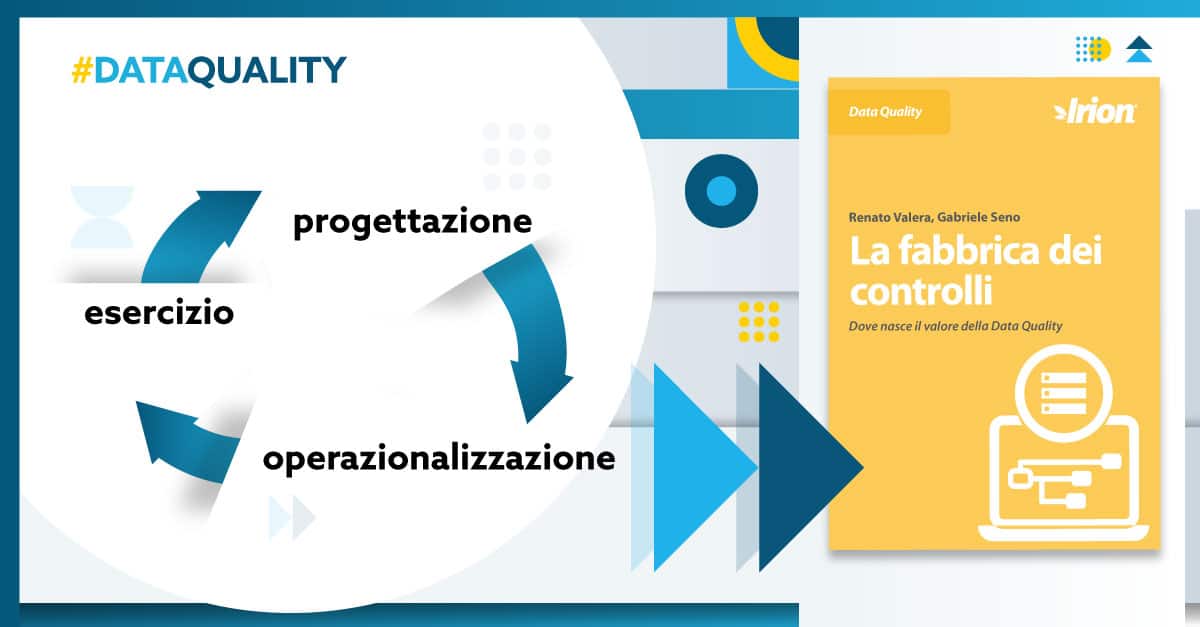

Scarica il white paper gratuito dei nostri esperti Renato Valera (Irion Head of Consulting & Analytics) e Gabriele Seno (Irion Product Evangelism & Advisory Leader) per scoprire nel dettaglio la definizione e l’evoluzione dei controlli di Data Quality (dimensioni di qualità, scopo, processo, volumi) e il modello di funzionamento di un sistema reale di DQ, nonché come avviene la “fabbrica dei controlli” nelle 3 fasi di progettazione, operazionalizzazione e messa in esercizio.

Infine, sempre nel documento in download qui sotto, troverai una overview e la value proposition della piattaforma Irion EDM e delle sue tecnologie distintive, i vantaggi dell’approccio dichiarativo e nativamente metadata-driven che la contraddistingue e la sua adattabilità a tutti i settori e le dimensioni aziendali con processi data intensive.

Scarica il white paper gratuito di Renato Valera e Gabriele Seno

La fabbrica dei controlli

Dove nasce il valore della Data Quality

Tra le tematiche trattate:

- La definizione e l’evoluzione dei controlli di Data Quality

- Come funziona un sistema di Data Quality?

- La fabbrica dei controlli: progettazione, operazionalizzazione, esercizio