Intelligenza Artificiale: microstoria, stato e prospettive

Il dibattito globale sulle potenzialità, sulle opportunità, sul ruolo e sui rischi derivanti dall’adozione e dalla diffusione di sistemi di intelligenza artificiale è in questo periodo giunto ad uno dei suoi punti più alti per intensità e ampiezza. Ma come molti sanno questa disciplina, che risorge periodicamente agli onori della cronaca, ha origini ormai remote.

Senza ripercorrere una storia centenaria di tentativi e ricerche finalizzate a simulare le capacità computazionali del cervello umano (da Blaise Pascal, a Charles Babbage, fino ad Alan Turing), possiamo collocare la nascita della “moderna” intelligenza artificiale nel 1955, anno in cui John MaCarthy coniò appunto questo termine. Negli anni successivi furono condotte ricerche e sperimentazioni in ambito accademico che posero le basi per le prime applicazioni pratiche in ambito industriale molti anni più tardi (siamo ormai negli anni 80). Da quel periodo in poi l’evoluzione di questa disciplina nelle sue declinazioni e connessioni (sistemi esperti, reti neurali, robotica, machine learning, AI generativa…), nonché negli ambiti di concreta applicazione è stata inarrestabile, con fasi, almeno agli occhi del grande pubblico, di stasi e di accelerazione improvvisa.

Come l’attuale, in cui la comparsa sul mercato di prodotti e servizi basati (realmente o per ragioni di marketing) sull’AI e recentemente il fenomeno ChatGPT hanno riacceso prepotentemente l’attenzione e l’interesse del mercato, della società e delle istituzioni. Le tecnologie di AI sono ormai diffuse in tutti i settori, utilizzate per finalità di business e nella vita quotidiana. Utilizziamo dispositivi domestici “intelligenti”, interagiamo con Customer Services supportati da ChatBot. Troviamo intelligenza artificiale, solo per fare alcuni esempi, nelle banche per valutare i rischi di credito, nelle assicurazioni per identificare le frodi, nelle aziende di servizio per analizzare il customer lifetime value della clientela e per individuare indizi di abbandono, nella pubblica amministrazione per lo smistamento automatico agli uffici competenti dei messaggi di posta elettronica certificata ricevuti. Ma al di là di questo pochi esempi gli ambiti di applicazione e i potenziali consumatori sono sempre più numerosi: come sempre l’interesse del mercato genera risorse per la ricerca e lo sviluppo di nuovi prodotti e servizi, che a loro volta alimentano le aspettative dei consumatori, in un ciclo evolutivo che ad oggi non sembra possa interrompersi.

Secondo le stime di PwC, pubblicate nel suo report “Sizing the price – PwC’s Global Artificial Intelligence Study: Exploiting the AI Revolution”,” il mercato globale dell’intelligenza artificiale vedrà una crescita annua del 37,3% tra il 2023 e il 2030, raggiungendo nel 2030 i 1.811,8 miliardi di dollari. L’AI avrà un impatto positivo sull’economia globale stimabile in 15,7 trilioni dollari entro il 2030.”

L’”S&P Global Market Intelligence report” del giugno 2023 prevede che il mercato della sola generative AI (quella di cui Chat GPT è l’esempio più noto) “raggiungerà i 3,7 miliardi di dollari nel 2023 e arriverà a 36,0 miliardi entro il 2028, con una crescita annua del 58%.” Secondo McKinsey queste tecnologie “potranno aggiungere all’economia globale l’equivalente di un valore annuale che va da 2,6 a 4,4 trilioni di dollari all’anno – per fare un confronto il PIL totale dell’United Kingdom nel 2021 è stato di 3,3 trilioni”.In Italia, una recente ricerca dell’Osservatorio “Artificial Intelligence” della School of Management del Politecnico di Milano rileva che “Il mercato dell’AI nel 2022 ha raggiunto 500 milioni di euro, con una crescita di ben il 32% in un solo anno. … Il 61% delle grandi imprese italiane ha già avviato almeno un progetto di AI, 10 punti percentuali in più rispetto a cinque anni fa. … Il 93% degli italiani conosce l’AI, il 58% la considera molto presente nella vita quotidiana e il 37% nella vita lavorativa. Il 73% degli utenti ha timori per gli impatti sul lavoro.”

Intelligenza Artificiale: una risorsa da presidiare

L’ultima cifra riporta l’attenzione sul dibattito relativo agli impatti, sia positivi sia negativi, che una tecnologia così diffusa e con queste previsioni di crescita può avere sulla società e sugli individui. Tra i rischi già da tempo paventati ricordiamo quelli più fantascientifici sulla ribellione della macchina nei confronti dell’uomo e quelli concreti sull’occupazione che, come ci dice la ricerca, sono ancora oggetto di timore per molti.

Esistono poi impatti reali o potenziali più legati alla violazione dei diritti. Facciamo un paio di esempi.

- Il rischio per una azienda o un individuo di non vedersi concedere un prestito da una banca che non lo ha concesso sulla base di un algoritmo di machine learning, senza che sia possibile spiegare al richiedente le ragioni del rifiuto (explainability)

- Il rischio che una decisione presa dalla direzione HR di un’azienda su suggerimento di un sistema AI abbia un esito negativo sull’assunzione di un candidato perché questo sistema è stato addestrato utilizzando dati che inducono un pregiudizio su determinate categorie (ad esempio sesso o etnia) (fairness – bias)

- Il rischio che un sistema AI venga progettato ed utilizzato da un’organizzazione per indurre comportamenti a proprio favore nei confronti di individui fragili o comunque condizionabili (fairness).

Le probabilità di accadimento di eventi come quelli sopra elencati, e non solo, si rivelano sempre più concrete quanto più sono alte la criticità e la numerosità dei sistemi AI gestiti da un’organizzazione. Questa considerazione porta a rendere ormai ineludibile la costituzione e l’esercizio costante di un presidio sul parco AI e sui relativi processi che ne governano il ciclo di vita, atto a scongiurare i rischi di cui sopra.

È una convinzione che anche le istituzioni a livello mondiale stanno facendo propria.

Requisiti normativi: l’AI Act

In particolare nel nostro continente, il Parlamento Europeo nel giugno 2023 ha dato il via libera all’AI Act, una regolamentazione che dovrebbe arrivare all’approvazione definitiva entro fine anno ed entrare in vigore nel 2024. SI tratta di una normativa, con un profilo sanzionatorio particolarmente alto (si arriva fino al 7% del fatturato globale annuo, più di quanto previsto dal Regolamento Europeo per la protezione dei dati personali – GDPR), che imporrà alle organizzazioni produttrici e utilizzatrici di sistemi di AI di adottare misure appunto di presidio del portafoglio AI.

In termini generali il Regolamento stabilisce che il ricorso all’intelligenza artificiale comporta il rispetto dei seguenti requisiti, ispirati a principi etici:

- Attuazione e supervisione umana

- Sicurezza e Robustezza tecnica

- Rispetto della Privacy e Data Governance

- Trasparenza

- Diversità, Non discriminazione e Correttezza

- Benessere sociale e ambientale

- Attribuzione delle responsabilità (Accountability).

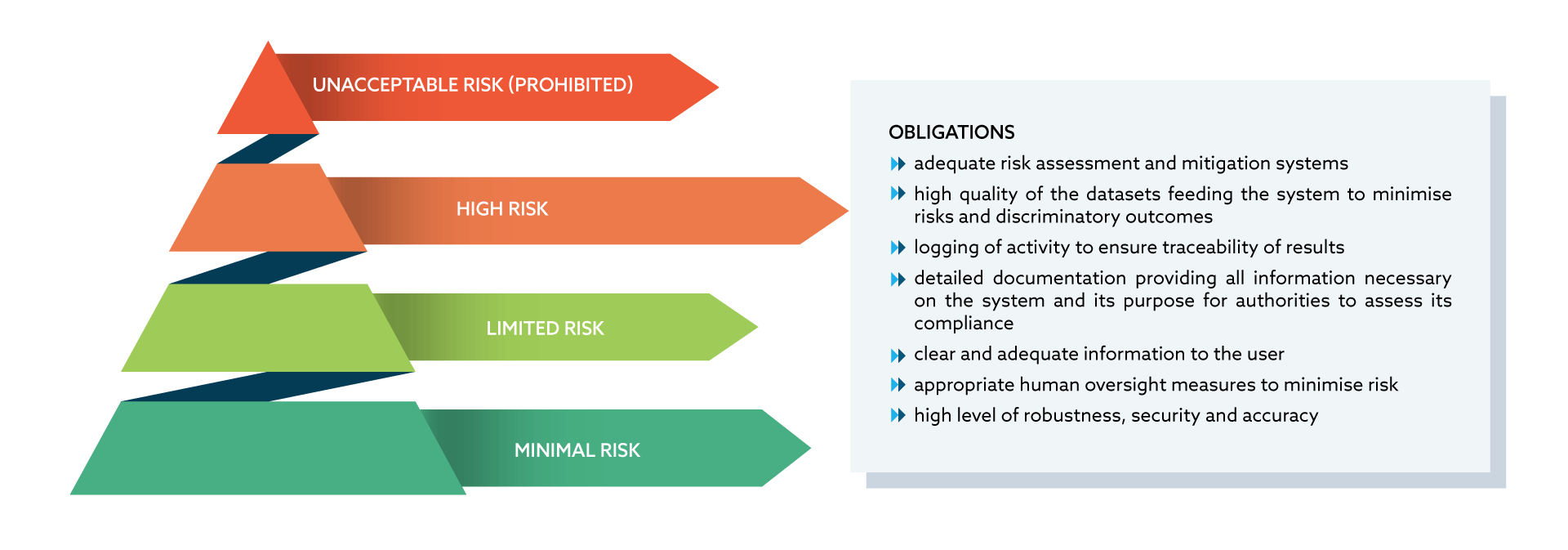

Il modello di governo dell’AI indicato dal Regolamento si fonda su un approccio basato sui rischi che impone la classificazione di ogni sistema AI in uno dei quattro livelli indicati in figura 1.

Fig. 1 – AI Act: Risk based approach

I sistemi a rischio inaccettabile sono quelli che

- presentano un elevato potenziale in termini di: manipolazione delle persone attraverso tecniche subliminali, senza che tali persone ne siano consapevoli; oppure di sfruttamento delle vulnerabilità di specifici gruppi vulnerabili, quali i minori o le persone con disabilità, al fine di distorcerne materialmente il comportamento in maniera tale da provocare loro o a un’altra persona un danno psicologico o fisico

- attribuiscono un punteggio sociale basato sull’IA per finalità generali da parte di autorità pubbliche

- applicano tecniche di identificazione biometrica remota “in tempo reale” in spazi accessibili al pubblico a fini di attività di contrasto, fatta salva l’applicazione di talune eccezioni limitate.

La realizzazione e l’impiego di questi sistemi è vietata.

I sistemi ad alto rischio sono quelli destinati a essere utilizzati

- per l’identificazione biometrica remota “in tempo reale” e “a posteriori” delle persone fisiche

- per valutare gli studenti negli istituti di istruzione e formazione professionale e per valutare i partecipanti alle prove solitamente richieste per l’ammissione agli istituti di istruzione

- come componenti di sicurezza nella gestione del traffico stradale e nella fornitura di acqua, gas, riscaldamento ed elettricità

- per l’assunzione o la selezione di persone fisiche o per adottare decisioni in materia di promozione e cessazione dei rapporti contrattuali di lavoro, per l’assegnazione dei compiti e per il monitoraggio e la valutazione delle prestazioni e del comportamento dalle autorità pubbliche o per conto di autorità pubbliche per valutare l’ammissibilità delle persone fisiche alle prestazioni e ai servizi di assistenza pubblica, nonché per concedere, ridurre, revocare o recuperare tali prestazioni e servizi

- per valutare l’affidabilità creditizia delle persone fisiche o per stabilire il loro merito di credito (con qualche eccezione)

- per inviare servizi di emergenza di primo soccorso o per stabilire priorità in merito all’invio di tali servizi dall’autorità di contrasto, come poligrafi o per rilevare lo stato emotivo di una persona, per individuare deep fake, per scongiurare il ripetersi di reati o accertare e perseguire reati attraverso attività di profilazione, per verificare i tratti o le caratteristiche criminali di individui o di gruppi, per l’analisi di correlazioni nascoste tra i dati utili alle attività di analisi criminale

- nell’ambito della migrazione, dell’asilo e del controllo delle frontiere da parte delle attività competenti, ad esempio per la verifica dell’autenticità dei documenti

- per assistere un’autorità giudiziaria nella ricerca e nell’interpretazione dei fatti e del diritto e nell’applicazione della legge a una serie concreta di fatti.

Per questi sistemi il Regolamento stabilisce una serie di obblighi:

- l’effettuazione di una analisi dei rischi e la messa in opera d misure per la loro mitigazione

- la garanzia di un’alta qualità dei dati, con l’obiettivo di minimizzare rischi di discriminazione

- il logging delle attività che hanno comportato l’utilizzo del sistema per assicurare la tracciabilità dei risultati

- una documentazione dettagliata del sistema e delle sue finalità di impiego

- un adeguato livello di supervisione umana

- trasparenza nei confronti dei soggetti sottoposti all’applicazione del sistema

- il rispetto di criteri di robustezza, accuratezza e cybersecurity.

Esistono poi sistemi non considerati ad alto rischio, ma per i quali si applicano comunque gli obblighi di trasparenza; sono essenzialmente i sistemi che

- interagiscono con gli esseri umani

- sono utilizzati per rilevare emozioni o stabilire un’associazione con categorie (sociali) sulla base di dati biometrici

- generano o manipolano contenuti (“deep fake”).

Per i sistemi che dall’analisi dei rischi non risultassero fare uso di tecniche di intelligenza artificiale o che, pur facendone uso, non presentassero profili di rischio significativi, non sono previste particolari misure, ma il Regolamento suggerisce comunque alcuni accorgimenti.

Quanto sopra illustrato non è esaustivo di tutte le indicazioni presenti nel Regolamento. Per una comprensione esaustiva dell’AI Act si rimanda alla pagina della Comunità Europea

Intelligenza Artificiale: come presidiarla

I requisiti regolamentari sopra riportati nonché la necessità concreta, al di là degli obblighi normativi, di gestire in modo consapevole e organizzato una risorsa che si rivela sempre più critica per il successo e per la sopravvivenza di un’organizzazione sollecitano a costituire o a consolidare un presidio dell’AI basato sui alcuni principi fondamentali.

Catalogazione del parco AI

Ogni sistema AI deve essere censito, catalogato, qualificato rispetto alle caratteristiche che ne consentano una classificazione rispetto ai rischi.

Governance

- Processi: è necessario definire processi specifici per la gestione del ciclo di vita dei sistemi di AI, dalla definizione dei requisiti, alla realizzazione, all’esercizio fino alla dismissione

- Ruoli e responsabilità: è necessario stabilire quali sono i ruoli che partecipano di processi di realizzazione, gestione, utilizzo dei sistemi AI; alcuni di essi si riferiscono ai singoli sistemi (ad esempio l’Owner o l’Utilizzatore), altri invece svolgono funzioni di coordinamento, regia, monitoraggio nel perimetro dell’intero sistema di governo dell’AI; per ognuno di questi ruoli devono essere definite le responsabilità lungo l’articolazione dei processi di cui al punto precedente; i ruoli devono poi essere assegnati in modo formale e non ambiguo a persone fisiche e/o a unità organizzative dell’organizzazione

- Metadati: usiamo per estensione questo termine, identificando con esso le informazioni che identificano e descrivono in modo strutturato Sistemi, Ruoli, Processi e tutte le altre entità in gioco nel sistema di gestione dell’AI

- Indicatori di performance: devono essere definiti e periodicamente misurato o calcolati indicatori in grado di rappresentare lo stato e l’evoluzione del sistema gestione dell’intelligenza artificiale; citiamo, a solo titolo di esempio, la percentuale di sistemi AI per i quali non è stata effettuata una catalogazione completa, oppure la percentuale dei sistemi ad alto rischio

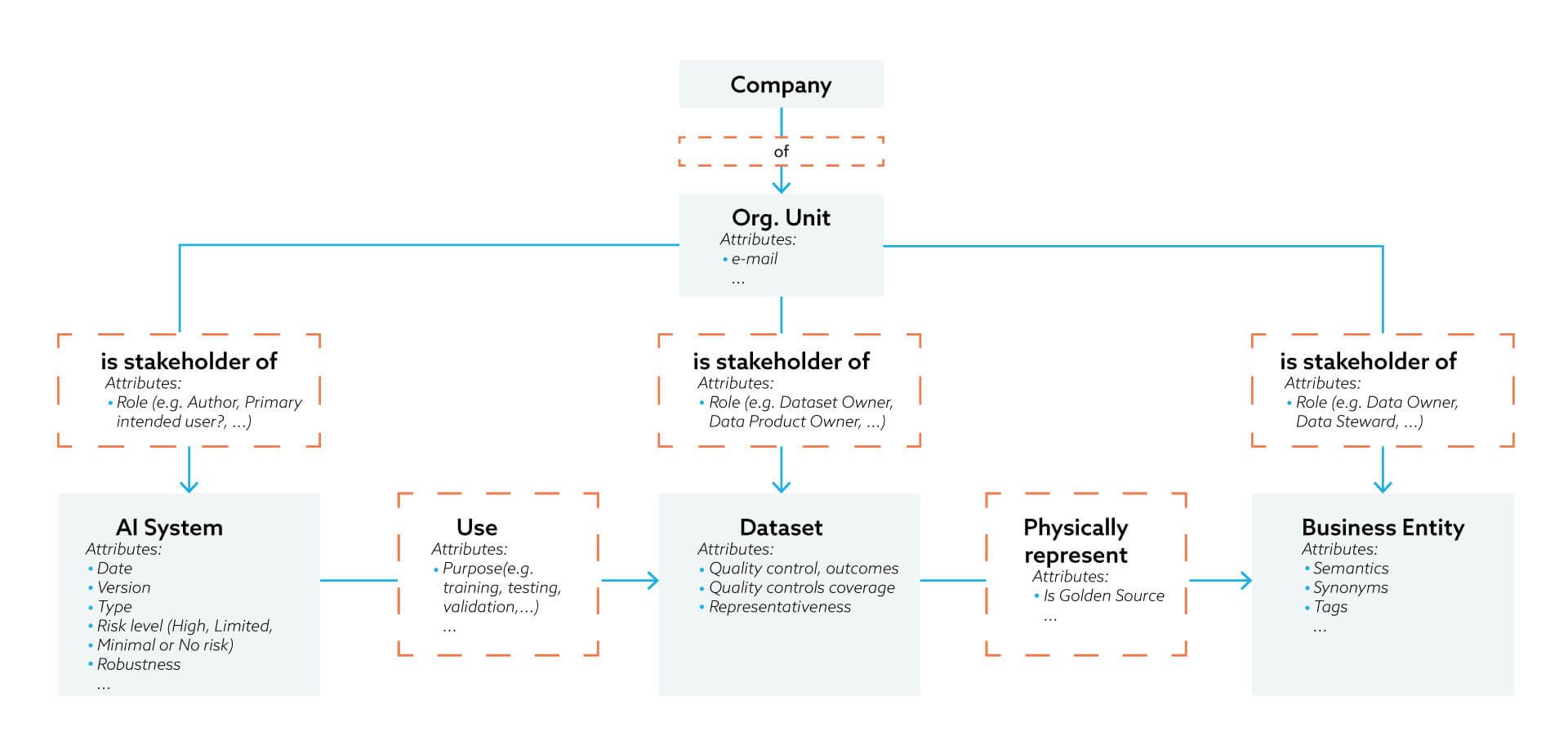

Integrazione con la governance e la gestione dei dati

Molti dei requisiti AI, sia regolamentari sia dettati da criteri interni all’organizzazione, hanno come elemento abilitante i dati impiegati ad esempio per il training, il testing, la validazione dei sistemi AI; per questa ragione è importante documentare quali dataset sono stati utilizzati a questo scopo, quali sono gli stakeholder che, all’interno dell’organizzazione hanno in carico la gestione di questi dataset, quali sono i controlli di qualità adessi applicati; spesso i ruoli previsti dal sistema di gestione dell’AI sono attribuiti alle stesse persone fisiche o alle stesse unità organizzative previste per il sistema di data governance; il modello di “metadati” illustrato in figura 2 rappresenta un esempio assolutamente non esaustivo di quale potrebbero essere le entità da presidiare in un sistema integrato di “Data & AI Governance”.

Fig. 2 – Data & AI Governance, Metadata Model

Flessibilità, Dinamicità

Dati, processi, modello di governance, ruoli, responsabilità del sistema di gestione AI devono poter essere sottoposti a revisione, integrazioni e modifiche nel tempo, per ragioni sia esterne (pur essendo consolidato nelle sue caratteristiche fondamentali, l’AI Act potrebbe ancora subire ritocchi prima della sua entrata in vigore e probabilmente anche successivamente), sia interne all’organizzazione (ad esempio interventi di riorganizzazione); per questa ragione il sistema di gestione AI deve garantire la possibilità di evolvere nel tempo in tutti i suoi elementi costituenti, a partire dal modello di metadati.

Irion per l’AI Governance

La piattaforma EDM (Enterprise Data Management) di Irion fornisce un set integrato di capabilities in grado di coprire tutti i principi sopra illustrati.

Il modulo di Open Data Governance garantisce l’estensione del modello di metadati a tutte le entità, le relazioni e gli attributi necessari per rappresentare il sistema di gestione AI; è possibile realizzare e mantenere un Catalogo dei Sistemi AI, integrarlo con i metadati del sistema di Data Governance, se disponibili, configurare processi, definire e attribuire ruoli agli stakeholder coinvolti, rilevare e calcolare indicatori.

Alle capability descrittive del Sistema, supportate da un potente motore grafico basato sul principio dei Knowledge Semantic Graph, Irion abbina funzionalità attive, quali l’orchestrazione dei processi configurati, l’implementazione e l’esecuzione di regole di qualità dei dati e di catalogazione dei sistemi AI, la gestione dei profili autorizzativi, l’integrazione con altri sistemi presenti nel system landscape dell’organizzazione, attraverso l’esposizione di API ed un catalogo di più di 200 connettori a differenti fonti informative e sistemi.