DataOps è l’insieme delle pratiche collaborative e delle tecniche chiave di Data Management incentrate sul miglioramento della comunicazione, dell’integrazione e dell’automazione dei flussi di dati tra i data manager e i data user in un’organizzazione.

DataOps è la contrazione dei termini “Data” & “Operations” e ha origine dalla disciplina DevOps (Software Development & IT Operations) adattandola ovviamente alle problematiche tipiche dei processi di analisi dei dati.

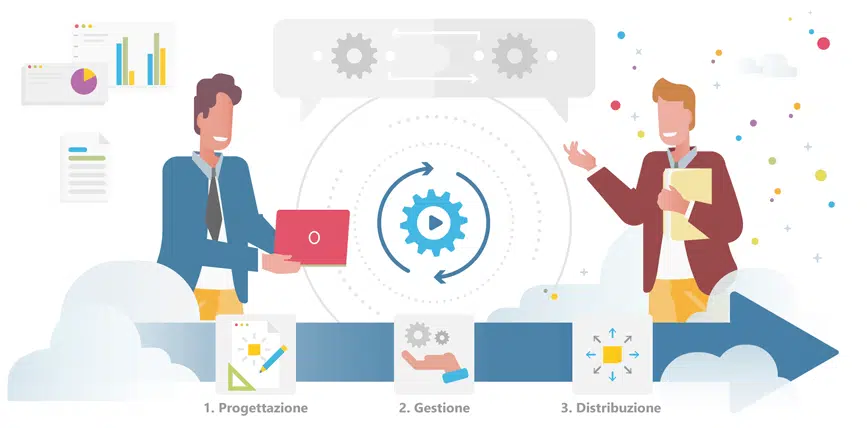

L’obiettivo di DataOps, sull’onda delle metodologie agile, è quello di fornire nuovi modelli di lavoro e collaborazione per generare più velocemente valore per l’azienda. DataOps utilizza la tecnologia per automatizzare la progettazione, la gestione e la distribuzione dei dati con livelli di governance appropriati, e impiega i metadati per migliorare l’usabilità e il valore delle informazioni in ambienti dinamici.

Come funziona DataOps?

Nei progetti in ambito Data & Analytics i cambiamenti di requisiti diventano più numerosi e importanti quanto più è lungo il tempo che intercorre tra la loro definizione iniziale e il go live della soluzione. In molti casi questi cambiamenti comportano una completa rilavorazione della data pipeline perché non esiste una visione comune, condivisa delle dipendenze e degli artefatti prodotti dai differenti ruoli dei team.

Per superare queste situazioni ed aumentare l’efficienza dei processi, in un mondo dove il volume di dati nelle aziende è in continua crescita, il DataOps manifesto evidenzia alcuni punti cardine quali la collaborazione (tramite scambio di feedback continui degli stakeholders), la qualità dei dati, rilasci frequenti in pieno stile agile, la reperibilità e le regole di governance volte a fornire pipeline di dati alle persone giuste, al momento giusto, da qualsiasi origine.

Ma entriamo nel dettaglio. In un recente documento di Gartner (Introducing DataOps Into Your Data Management Discipline, 31 October 2019, Ted Friedman & Nick Heudecker), sono elencate le principali sfide che i Data & Analytics leader si trovano ad affrontare nell’implementazione e nell’esercizio di moderne soluzioni data intensive e si suggerisce un percorso per insediare un modello di gestione in grado di vincere queste sfide. Ecco le principali caratteristiche di questo paradigma:

- incremento della frequenza dei rilasci — rilasci rapidi e veloci di nuove funzionalità, apprezzabili dai committenti, che agevolano la gestione di cambiamenti nei requisiti, sia nella fase progettuale che durante l’intero ciclo di vita delle soluzioni;

- Automazione dei test — ridurre il coinvolgimento umano nelle fasi di test, ad esempio dei test di non regressione, consente di velocizzare i rilasci;

- Gestione dei metadati e delle versioni — l’incremento della frequenza e del numero di rilasci impone la presenza di un sistema di controllo delle versioni; inoltre, ogni versione di una soluzione data intensive comporta variazioni esprimibili attraverso metadati; questi metadati, resi disponibili a tutti i ruoli che partecipano alla data pipeline garantiscono una gestione efficace e condivisa dei cambiamenti;

- Monitoraggio costante — una tracciatura nel continuo del funzionamento e dell’utilizzo della data pipeline consente di identificare e indirizzare malfunzionamenti e opportunità di miglioramento delle funzionalità e delle prestazioni;

- Collaborazione tra tutti i ruoli coinvolti — Una costante comunicazione tra tutti gli attori interessati, basata su metadati disponibili in un ambiente collaborativo è fondamentale per garantire rilasci rapidi di componenti di qualità.

Per abilitare le pratiche di DataOps è quindi necessario:

- poter estrarre dati da una miriade di fonti (ovunque risiedano cloud o on premise),

- allinearli in un catalogo di metadati flessibile (in cui i dati sono facilmente accessibili, taggabili, annotabili, arricchibili e condivisibili),

- automatizzare i test,

- abilitare un monitoraggio continuo consentendo alle organizzazioni di orchestrare efficacemente i loro attuali sistemi di gestione dei dati per poter potenziare le loro prestazioni e facilitare così l’attività dei Data Engineer, Data Scientist, Data Analyst, Data Stewart, Data Owner, Data User, …

Tutte capabilities fondamentali per valorizzare il patrimonio informativo di un’azienda alla velocità e con la qualità richieste dal business dei nostri tempi. Questi sono principi che da sempre guidano l’evoluzione, al servizio dei propri clienti, di Irion EDM.

Vuoi saperne di più?

Ti illustreremo con esempi pratici come le altre realtà

hanno già avviato la loro trasformazione.